深圳人工智能软件应用示范申报中的软件测试报告要点解析

在深圳市积极推动人工智能产业发展的背景下,人工智能软件应用示范项目申报已成为企业获取政策支持、展示技术实力的重要途径。一份严谨、专业的软件测试报告,不仅是申报材料的核心组成部分,更是体现人工智能应用软件开发质量与可靠性的关键证明。本文将围绕深圳人工智能软件应用示范申报的要求,阐述软件测试报告在人工智能应用软件开发过程中的重要性及其核心内容框架。

软件测试报告是评估人工智能应用软件是否达到示范应用标准的重要依据。它系统地记录了软件的功能、性能、安全性、可靠性及伦理合规性等方面的测试过程与结果。对于人工智能软件而言,测试尤其需要关注其算法模型的准确性、稳定性、泛化能力以及对边界案例的处理。报告应详细说明测试环境(包括硬件配置、软件依赖、数据集来源与特征)、测试方法(如单元测试、集成测试、系统测试、专项的AI模型测试如对抗性测试、公平性测试等)以及采用的测试工具与框架。

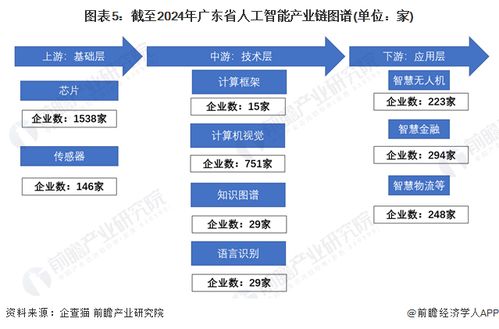

针对深圳的申报特点,测试报告需紧密贴合示范应用场景。报告应明确阐述软件在拟申报的特定领域(如智慧医疗、智能交通、金融科技、智能制造等)中的实际应用测试情况。这包括在模拟或真实场景下的运行表现、解决实际问题的效能提升数据、以及与现有解决方案的对比分析。例如,一个智能诊断软件,其测试报告需包含对大量临床数据的测试结果,展示其诊断准确率、敏感度、特异性,并说明其如何辅助医生决策、提升诊疗效率。

报告的核心内容应结构化呈现:

- 概述:简要介绍被测人工智能软件的名称、版本、开发单位,以及本次测试的目的、范围(特别是与示范应用相关的核心功能模块)和依据的标准或规范。

- 测试环境与工具:清晰描述测试所需的软硬件环境、网络配置,以及用于功能、性能、安全测试和模型评估的专用工具(如TensorFlow/PyTorch的测试模块、LoadRunner、AppScan等)。

- 测试过程与用例:详细记录测试执行过程,包括针对AI特性的测试,如不同数据集下的模型再训练与验证测试、算法偏见检测、对抗样本鲁棒性测试等。提供关键测试用例的设计思路与执行步骤。

- 测试结果与分析:这是报告的主体。需以数据、图表等形式客观呈现各项测试指标的结果,例如:

- 功能测试结果:核心AI功能(如识别、预测、决策)的通过率。

- 性能测试结果:响应时间、吞吐量、并发用户支持能力、模型推理速度、资源(CPU/GPU/内存)占用率等。

- 安全与合规测试结果:数据隐私保护措施的有效性(是否符合《网络安全法》《数据安全法》及深圳相关数据条例)、系统抗攻击能力、算法公平性与可解释性评估。

* 稳定性与可靠性测试结果:长时间运行下的错误率、崩溃频率、自恢复能力等。

并对未通过的测试项进行缺陷分析,说明原因及解决方案或规避措施。

- 风险评估与建议:基于测试结果,识别软件在示范应用中可能存在的技术风险、操作风险或伦理风险,并提出优化改进建议。

- 结论:明确给出软件是否满足设计需求、是否具备在申报场景下进行示范应用的质量要求的结论性意见。

测试报告的真实性、权威性至关重要。建议由独立的第三方测试机构出具,或由企业内部的独立测试部门完成,并附上测试人员签名及单位盖章,以增强其公信力。在申报材料中,一份内容详实、数据准确、结论清晰的软件测试报告,能够有力证明人工智能应用软件开发的专业性与成熟度,显著提升项目在深圳市人工智能软件应用示范申报中的竞争力。

如若转载,请注明出处:http://www.thorminigrid.com/product/53.html

更新时间:2026-03-01 15:12:54